Новые сайты, созданные в период с марта по май и имеющие связи с Россией, использовали ИИ для создания дезинформирующего контента — сообщал France 24 в начале июня. Используя статьи авторства мнимых журналистов или манипулирующие изображения, эти сайты с помощью искусственного интеллекта могут мимикрировать под достоверные СМИ. Однако, внимательно проанализировав сайт, можно попытаться определить, является ли он небезопасным и искусственно созданным.

В своем материале телеканал France 24 дает несколько советов о том, как выяснить, был ли сайт создан с помощью ИИ. Вот на что следует обратить внимание:

- Проверка логотипа сайта. Логотипы, сгенерированные ИИ, таким как DALL-E 3, могут содержать бессмысленные надписи или очевидные ошибки.

- Определение следов подсказок в статьях. Ищите в тексте «утечки» или ошибки, характерные для ИИ. Например, заголовки, включающие такие примечания, как «этот заголовок краткий и точный», указывают на то, что текст был сгенерирован искусственно в соответствии с инструкциями пользователя.

- Проверка надежности источников. Многие статьи могут ссылаться на несуществующие или ненадежные источники.

- Выявление «галлюцинаций» ИИ. Искусственный интеллект может совершать фактологические ошибки.

- Изучение технической инфраструктуры и исходного кода сайта. Анализ исходного кода может выявить технические связи между сайтами, задействованными в операциях по дезинформации.

- Проверка биографий журналистов. У мнимых журналистов могут быть несуществующие профили.

Тем не менее, некоторые эксперты предупреждают, что выявление искусственно созданного портала — дело непростое. В интервью Mediacritica тренер курса «Искусственный интеллект в журналистике» Кишиневской школы журналистики Пол МакНелли утверждает, что в настоящее время «существует множество инструментов, якобы способных обнаруживать ИИ, но по большей части они не работают». «Ни один из методов не является безупречным, и я не уверен, сможем ли мы дать общие рекомендации. Существует множество инструментов, якобы способных обнаруживать ИИ, но по большей части они не работают. Кроме того, когда есть крупные сайты, такие как Associated Press, которые заявляют, что 80% их рабочего процесса будет генерироваться искусственным интеллектом (и лишь оставшиеся 20% — людьми), думаю, вопрос о том, что означает “слишком много ИИ”, имеет решающее значение», — уточнил тренер.

А по мнению предпринимателя Виталия Ешану, «поддельные порталы можно обнаружить, так как они используют странные слова. Это потому, что ИИ обычно думает на английском языке, а затем выполняет перевод. Кроме того, сайт, созданный ИИ, могут выдать стиль и использование сложных слов. Но это не значит, что завтра владельцы не начнут использовать другие методы для устранения подобных недочетов».

В то же время Виталий Ешану считает, что «теоретически невозможно определить, написан ли текст ИИ, тем более что с каждым месяцем эти тексты становятся все лучше и лучше. Что касается звука, изображений и видео, крупные компании, которые их создают, могут тайно внедрять определенные маркеры, незаметные для человеческого глаза или уха. Их можно обнаружить алгоритмически. Однако желающие манипулировать будут использовать не эти ИИ, а другие, которые подобного не делают. Начинается новый этап в fake-news и true news, и неизвестно, куда он нас приведет».

«Задумка в том, чтобы с помощью ИИ добросовестные журналисты могли ускорить создание и распространение информации, поскольку генерирование фальшивых новостей остановить невозможно. Сейчас обрабатывать информацию вручную довольно дорого, и в этом смысле ИИ может взять на себя часть работы. Таким образом, достоверные новости смогут конкурировать с вредоносными. Другого пути я не вижу», — прогнозирует Ешану.

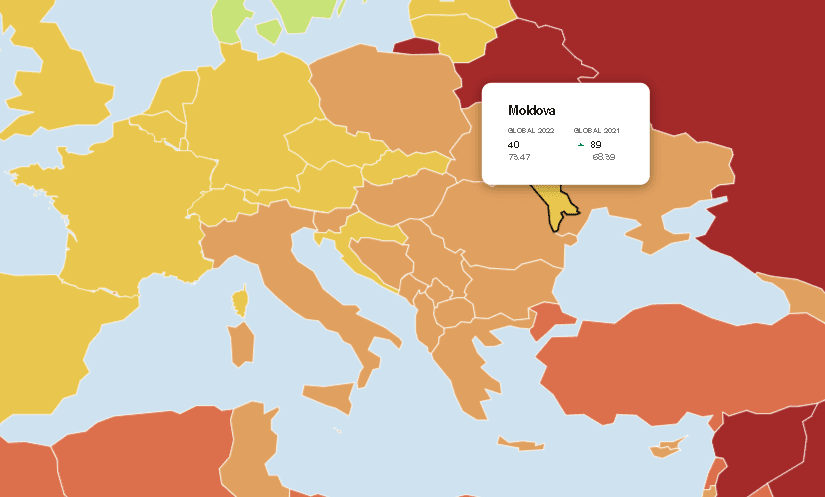

Ранее Mediacritica писала о «розовой слизи» (pink slime journalism). Данное понятие описывает сайты, которые играют роль местной прессы, но дают мало реальной информации. Они часто создаются автоматически и также часто используют пристрастные способы подачи информации.