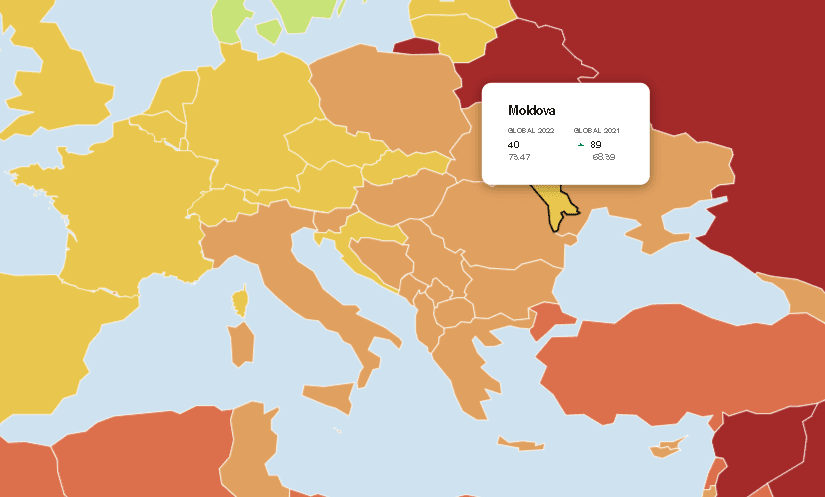

Технологии Deepfake, способные реалистично синтезировать образы и голоса, могут существенно влиять на мнение и голосование избирателей во время избирательных кампаний, оказывая серьезное влияние на демократический процесс, предупреждает Национальное управление по кибербезопасности Румынии (DNSC) в год, когда в 77 странах мира проводятся выборы, включая Румынию и Республика Молдова. В недавно выпущенном Руководстве ведомство объясняет, почему дипфейки представляют опасность в контексте выборов.

По данным DNSC, в случае выборов технологии дипфейков могут оказать решающее влияние на политиков, политические партии и определенные группы интересов.

В случае с политиками их репутация может быть серьезно подорвана сфабрикованными дипфейковыми видеороликами, которые могут дискредитировать их имидж и снизить их шансы на победу на выборах. Распространение дезинформации посредством дипфейков может манипулировать общественным восприятием характера и программы политика, негативно влияя на его или ее политическую карьеру.

В случае политических партий дипфейк может использоваться как стратегический инструмент для дискредитации конкурирующих партий путем создания фейковых материалов, изображающих их в негативном свете. Продвижение повестки партии с помощью дипфейков может стать эффективным способом повлиять на общественное мнение и привлечь избирателей. Неправильное использование партиями дипфейков может привести к скандалам и потере доверия общества к политической системе.

В случаегрупп интересов, дипфейк может использоваться такими организациями внутри страны для манипулирования общественным мнением по гражданским вопросам. Создание фальсифицированного контента, адаптированного к местному контексту, может усилить или снизить недовольство по поводу конкретных проблем или событий. Использование дипфейков заинтересованными группами может привести к поляризации общества и эрозии демократического общественного дискурса.

По данным источника, наиболее распространенными методами дипфейка, используемыми для влияния на избирательные кампании, являются:

• Реалистичная подделка видео. Передовые алгоритмы искусственного интеллекта создают видеоролики, практически неотличимые от реальных, с фальшивыми сценами с участием политиков или вымышленными событиями.

• Клонирование голоса и подмена звука. Голос политика воспроизводится с поразительной точностью, создавая фейковые сообщения, ошибочно приписываемые этому человеку.

• Генерирование синтетического текста. Создаются заслуживающие доверия тексты, имитирующие стиль и тон политического деятеля или учреждения, распространяющие дезинформацию.

• Изменение лиц. Технология позволяет изменять лица в видеороликах, создавая ложные сценарии, которых никогда не было или которые не происходили в показанном контексте.

•Поведенческое прогнозирование. Искусственный интеллект анализирует поведение в Интернете, чтобы предсказать реакцию на определенные сообщения, что упрощает создание целевых дипфейков для влияния на определенные сегменты избирателей.

«Эти приемы могут быть использованы злоумышленниками для дискредитации кандидатов, манипулирования общественным мнением и подрыва доверия к избирательному процессу. Крайне важно осознавать опасность дипфейков и принимать меры по борьбе с дезинформацией и защите честности выборов», — говорится в Руководстве DNSC.

Ранее Mediacritica предупреждала о дипфейковых видеоматериалах, чаще всего направленных против президента Майи Санду. В одном из случаев в клипе была изображена женщина, снятая в реальности, одетая в черное и с покрытой головой, но ее лицо было заменено на лицо Майи Санду, как и её голос. В другом случае речь шла о видео, касающегося «создания инвестиционной платформы совместно с MAIB, которая позволит гражданам зарабатывать по 30 000 леев в месяц», в котором глава государства, якобы, призвала граждан присоединиться к проекту, что является ложью.