Ежедневно молдавский TikTok «заполоняют» манипулятивные или фейковые видеоролики, созданные частично или полностью с помощью инструментов искусственного интеллекта. Их тематика во многом совпадает с дезинформационными нарративами, продвигаемыми в этот же период политиками, инфлюенсерами и анонимными аккаунтами, связанными с Российской Федерацией или Иланом Шором

- В ходе предыдущих мониторингов, в которых мы использовали предопределенный список хэштегов для выявления дезинформационных нарративов в контексте предстоящих выборов, мы выявили десятки фейковых видеороликов, созданных с помощью ИИ, которые продвигали «классические» нарративы, такие как «втягивание Молдовы в войну» или «вмешательство Франции в выборы в Республике Молдова». Однако в последнее время используются распространенные хэштеги, такие как #moldova или #chișinău, что позволяет им просачиваться среди сотен видеороликов, ежедневно публикуемых реальными пользователями.

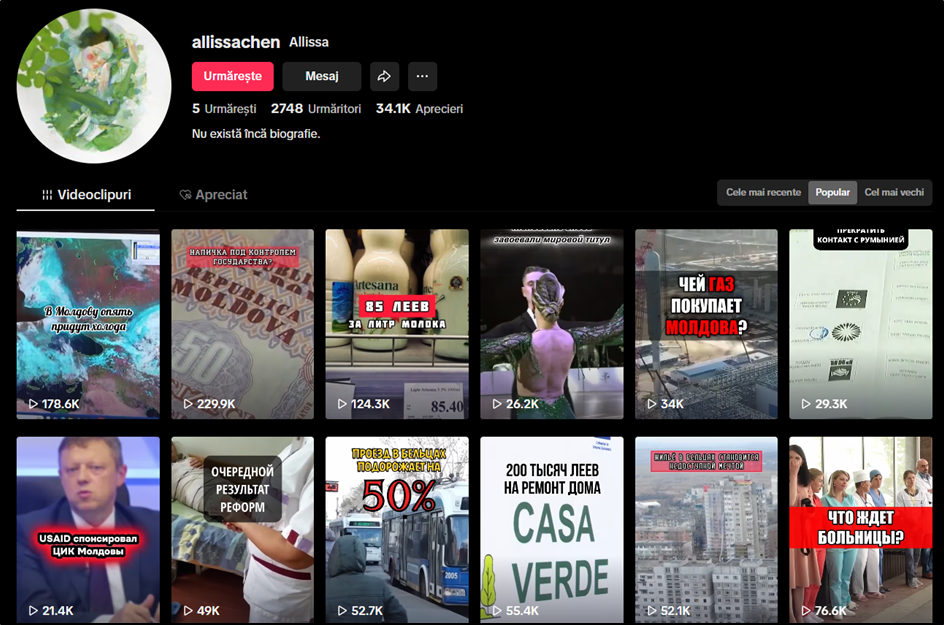

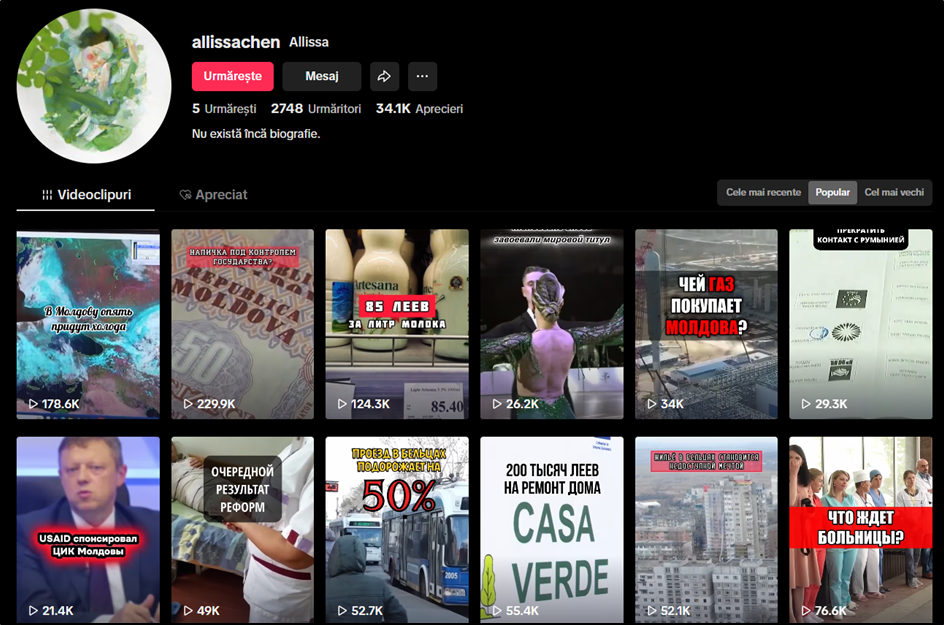

- Значительная часть аккаунтов, участвующих в распространении искусственно сгенерированных фейков, не обладает типичными характеристиками подлинных аккаунтов: у них нет значительного количества пользователей и длительной истории активности. Однако, при индивидуальном анализе обнаружено, что такие видеоролики достигают десятков и даже сотен тысяч пользователей.

Знакомые, но искусственные голоса

Чаще всего, по нашим наблюдениям, манипулятивные нарративы распространяются посредством коротких видеороликов в стиле fast news (быстрые новости), озвученных с помощью искусственного интеллекта. В некоторых случаях воспроизводимый звук настолько точно имитирует человеческий голос, что интернет-пользователи могут легко спутать его с голосом реального человека. В других случаях присутствие искусственного интеллекта выдается роботизированной интонацией, неправильным произношением или неестественными паузами. В любом случае, видеоролики достигают своей цели, оказывая воздействие и донося до аудитории заданные сообщения.

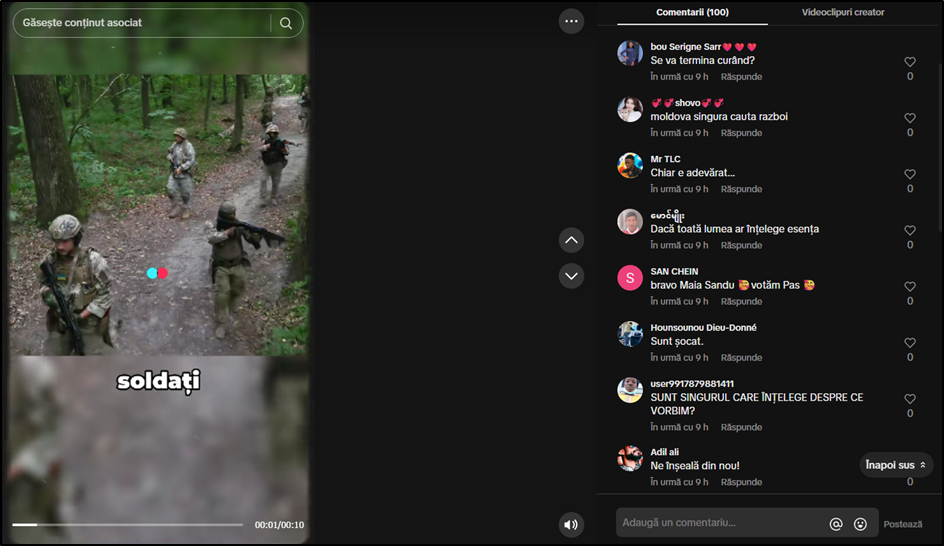

Одним из примеров является фейк, о котором и ранее сообщала Mediacritica, – о прибытии 800 солдат НАТО в Республику Молдова перед выборами.

В «озвученном» с помощью искусственного интеллекта видеоролике эта сфабрикованная информация представлена как вмешательство в парламентские выборы 28 сентября. Примечательно, что искусственный интеллект подвел авторов и вместо военных объявил о прибытии в Республику Молдова «800 спартанцев». Этот фейк фактически подпитывает некоторые из нарративов, постоянно продвигаемых российской пропагандой в последние месяцы: вооружение Молдовы и втягивание ее в войну, внешний контроль и намерение сфальсифицировать выборы.

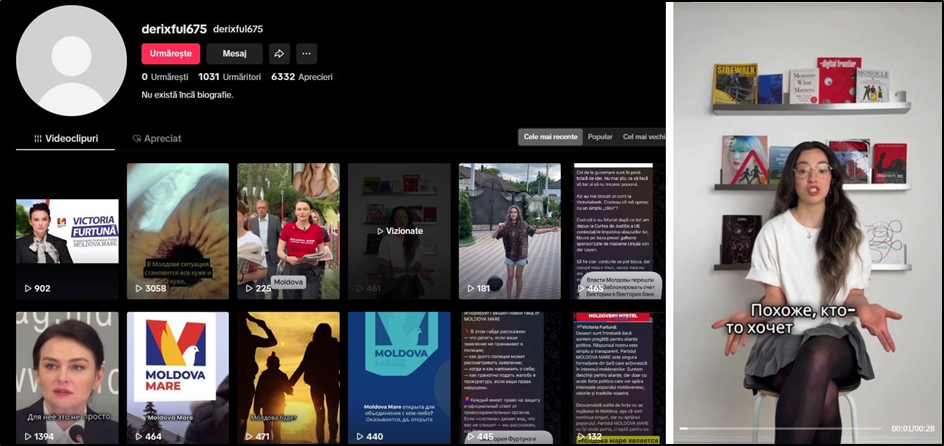

Страница, опубликовавшая это видео и еще многие другие посты, созданные с помощью искусственного интеллекта, выпускает контент с президентских выборов 2024 года, и ее видеоролики набрали более 100 000 просмотров.

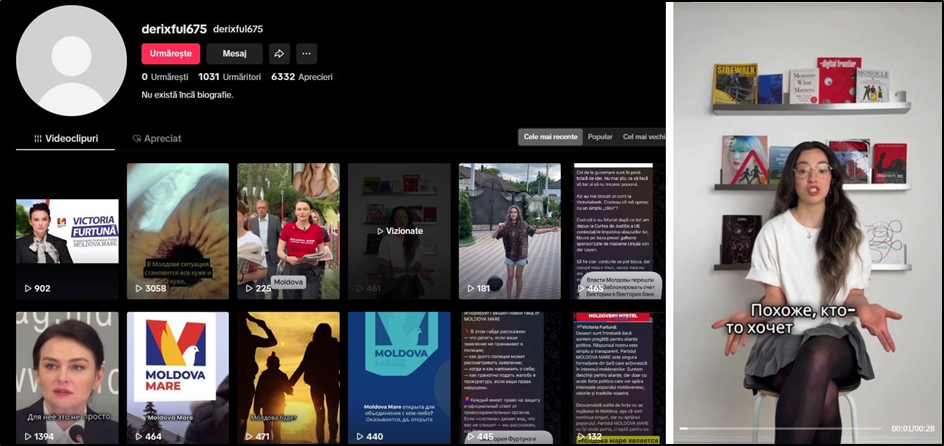

На другой странице, использующей контент, созданный с помощью искусственного интеллекта, было опубликовано видео о «разделении страны по религиозному признаку». Сообщение озвучено поддельным голосом, наложенным на изображения, взятые из другого источника. Другими словами, изображение выглядит реальным, но голос сгенерирован искусственно.

Этот подход, скорее всего, использовался для создания впечатления, что сообщение принадлежит реальному человеку.

На этой же странице публикуются преимущественно материалы, благоприятствующие Виктории Фуртунэ и представляющие ее в выгодном свете. В другом видео, например, показана предвыборная поездка политика. На этот раз и голос, и фигура человека, «говорящего» в углу экрана, были созданы с помощью искусственного интеллекта.

Несуществующие «бабушки»

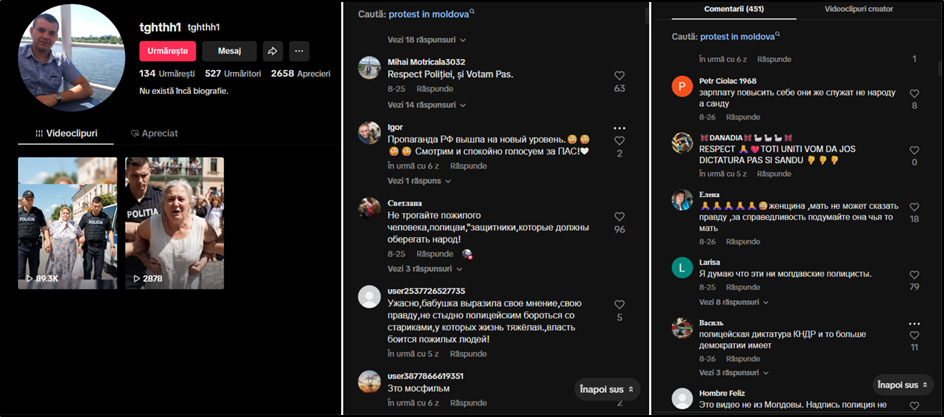

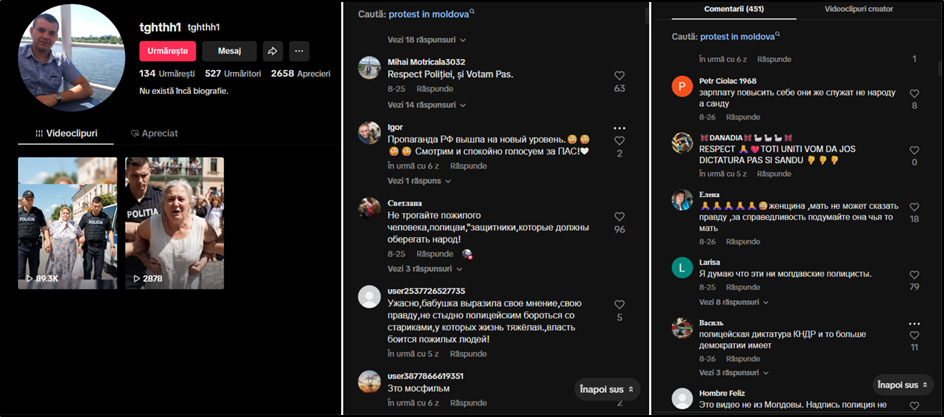

В августе несколько пропагандистских источников и аккаунтов обратили свое внимание на приговор башкану Евгении Гуцул к семи годам лишения свободы по делу о незаконном финансировании бывшей партии «Шор». Эта тема продвигалась гораздо активнее других актуальных событий в общественной повестке, как блогерами, связанными с Иланом Шором, так и посредством видеороликов, созданных с помощью искусственного интеллекта. Красноречивым примером служат «бабушки», схваченные полицией за «выход в защиту» Евгении Гуцул.

Тема видеороликов практически одинакова: пожилая женщина кричит «Свободу Гуцул!» и спрашивает: «Почему меня задерживают?». Помимо попытки создать ложную иллюзию народной поддержки башкана, сообщение направлено на то, чтобы донести до людей мысль о том, что полиция превышает свои полномочия и что в Республике Молдова людей задерживают или преследуют по политическим мотивам.

Одно из этих видео, очевидно созданное с помощью искусственного интеллекта, набрало почти 90 000 просмотров. В комментариях несколько реальных пользователей либо осуждают, либо поддерживают жест «полиции».

В последнее время, помимо Илана Шора, «бабушки» также начали активно выступать в поддержку задержанного в Греции Владимира Плахотнюка. В видеоролике созданном с помощью искусственного интеллекта главная героиня утверждает, что была бы рада возвращению бывшего лидера ДП в политику, поскольку ей «надоела эта желтая ПДС».

В другом видео, набравшем более 200 000 просмотров, трое пожилых людей поют и зовут Плахотнюка домой, чтобы тот «сверг Майю».

Бэтмен «прибывает» в Республику Молдова по «приглашению» ПСРМ

Искусственный интеллект используется в TikTok не только для создания иллюзии реальных людей и событий. В некоторых случаях он служит инструментом грубой манипуляции, с помощью которого продвигаются ложные нарративы посредством полностью сгенерированных изображений, явно не соответствующих действительности.

Например, в видеоролике, утверждающем, что «Майя Санду контролирует систему правосудия», изображение президента размещается рядом с символами ЛГБТК+-сообщества, прибегая к гомофобии для ее демонизации.

В других случаях глава государства появляется в аккаунтах, распространяющих контент в поддержку Илана Шора, в экстремальных ипостасях: рядом с демоном или в образе мифического существа. Эти изображения, сопровождаемые манипулятивными текстами, намекают на то, что Майя Санду уничтожает Молдову. Их целевая аудитория ‒ русскоязычное население.

Мы также выявили видеоролики, в которых правящая партия представлена как коррумпированная, с помощью образов, призванных воздействовать на эмоции. Люди, одетые в цвета и символику партии «Действие и солидарность», изображены ворующими деньги у матери с тремя детьми или у пожилых людей, чтобы создать впечатление, что правительство грабит самых уязвимых.

Некоторые нарративы развиваются более креативными методами. Например, аккаунт в TikTok опубликовал несколько видеороликов, созданных с помощью искусственного интеллекта, в которых персонаж Бэтмен «прибывает» в Республику Молдова. Некоторые из этих видеороликов имеют политический подтекст: супергерой представлен как приглашенный «Игорем Николаевичем» [Додоном, прим. авт.] для противостояния Майе Санду.

В других эпизодах Молдова изображается как государство, находящееся в кризисе: с плохими дорогами, парадами ЛГБТК+ и правительством, которое описывается как «состоящее из воров». Кульминацией повествования становятся кадры, где Бэтмен ведет в сторону Кишинева граждан с крестами и вилами в руках.

Упомянутые видеоролики отличаются от привычных шаблонов скоординированной пропаганды и, возможно, были созданы отдельными пользователями, исходя из их собственных политических взглядов. Однако это не отменяет того факта, что они распространяют вредоносные идеи и даже разжигают ненависть.

Искусственная паника в комментариях

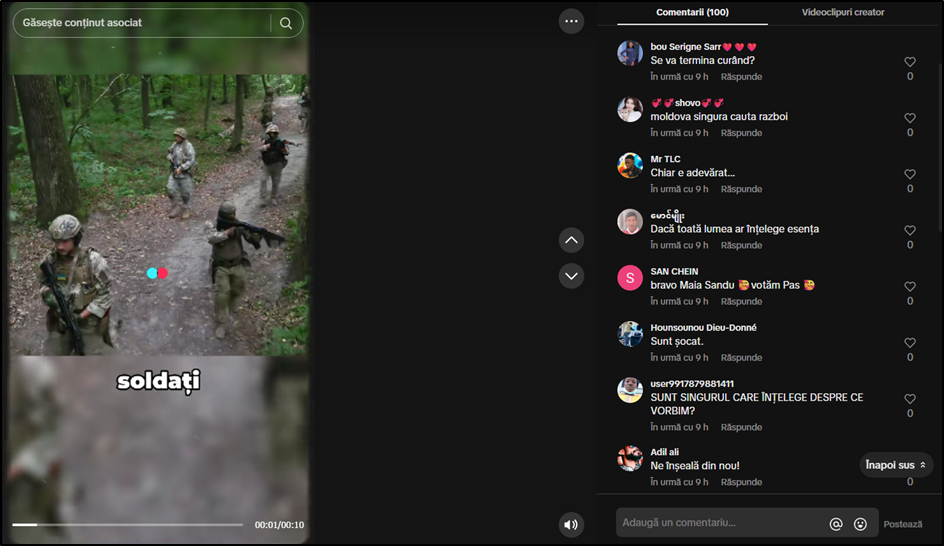

Наряду с визуальными и звуковыми элементами, дополнительным инструментом манипулирования аудиторией часто служит раздел комментариев. Например, фейковый видеоролик об «участии Молдовы в войне в Украине» сопровождается комментариями на румынском языке, написанными пользователями из Мьянмы, Бангладеш или Бенина. В одном из них говорится, что «люди не понимает сути», в другом ‒ что «Молдова сама ищет войны», а в третьем профиле утверждается, что ситуация в нашей стране «шокирует».

Поддельные комментарии в основном используются для искусственного повышения видимости и создания мнимой достоверности контента. Создавая кажущуюся популярность, алгоритмы платформы стимулируют распространение материала, что объясняет, почему одно из проанализированных нами видео преодолело порог в 100 000 просмотров. В то же время, такие комментарии активируют эффект социального конформизма («стадный эффект»), когда пользователи склонны принимать мнение кажущегося большинства и редко интересуются истинной личностью тех, кто его формулирует.

ВЫВОДЫ

Год назад с помощью искусственного интеллекта ежедневно создавалось около 34 миллионов фотографий. Объем контента, создаваемого с помощью ИИ, стремительно и неуклонно растет и стал частью информационных и гибридных войн, и Республика Молдова не является исключением. В предвыборный период и во время избирательных кампаний фейковые видеоролики, создаваемые и распространяемые в TikTok, представляют собой опасный инструмент манипуляции.

Используя правдоподобные искусственные голоса, сфабрикованные изображения и фейковые комментарии, которые формируют ложную социальную легитимность, эти материалы искажают общественное восприятие реальности и подрывают доверие граждан к избирательному процессу, государственным институтам и демократии в целом.

В условиях нестабильной избирательной ситуации подобные практики увеличивают риск поляризации и радикализации, превращая социальные сети в уязвимое пространство для информационной безопасности Республики Молдова.

Мониторинг был проведен в рамках проекта «Устойчивая пресса, информированные избиратели: защита выборов в Молдове от дезинформации», финансируемого Посольством Королевства Нидерландов в Молдове. Высказанные мнения принадлежат авторам и не обязательно отражают позицию донора.

Доступ к инструменту мониторинга TikTok был предоставлен в рамках проекта «ProElect — Содействие повышению подотчётности в избирательных процессах в странах Восточного партнёрства через расширение участия и укрепление потенциала гражданских акторов», реализуемого Центром исследований и адвокации в европейских делах при финансовой поддержке Европейского Союза и Equal Rights & Independent Media (ERIM).