TikTokul moldovenesc este „invadat” zilnic de videouri manipulative sau false, create parțial sau în totalitate cu instrumente de inteligență artificială. Subiectele lor coincid, în mare parte, cu narațiunile de dezinformare promovate în aceeași perioadă de politicieni, influenceri și conturi anonime asociate cu Federația Rusă sau Ilan Șor.

- În cadrul monitorizărilor anterioare, în care am utilizat o listă predefinită de hashtaguri pentru a identifica narațiuni de dezinformare în context electoral, am identificat zeci de videouri false, generate cu AI, care promovau narațiuni „clasice” precum „atragerea Moldovei în război” sau „implicarea Franței în alegerile din Republica Moldova”. Mai nou, însă, se folosesc doar hashtaguri comune, precum #moldova sau #chișinău, reușind astfel să se infiltreze printre sute de videouri publicate zilnic de utilizatori reali.

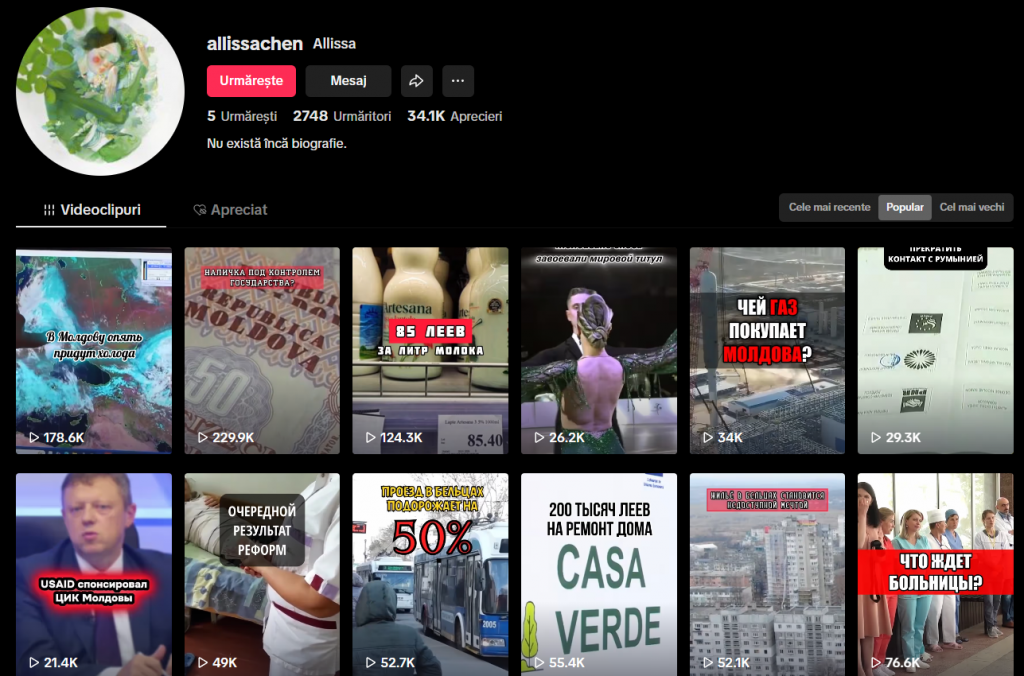

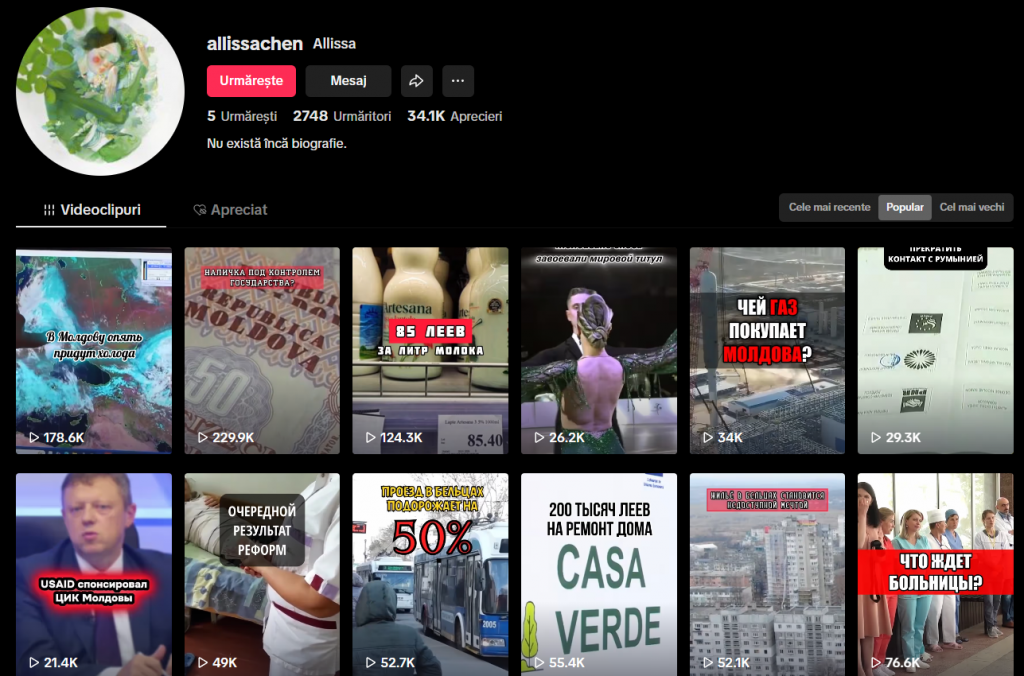

- O mare parte a conturilor implicate în distribuirea falsurilor generate artificial nu prezintă caracteristici tipice ale conturilor consolidate: nu au un număr semnificativ de utilizatori și nu dețin un istoric îndelungat de activitate. În schimb, analizate individual, astfel de videoclipuri reușesc să ajungă la zeci și chiar sute de mii de utilizatori.

Voci familiare, dar artificiale

Cel mai des, din observațiile noastre, narațiunile manipulative sunt răspândite prin videouri în stil fast news (știri scurte), cu voci generate de AI. În unele cazuri, sunetul redat imită cu acuratețe vocea umană, încât internauții îl pot confunda cu ușurință cu cea unei persoane adevărate. În alte cazuri, prezența inteligenței artificiale este trădată de tonalitatea robotică, pronunția greșită sau pauzele nefirești. În oricare dintre cazuri, videourile își ating scopul, având impact și reușind să transmită mesajele intenționate către public.

Un exemplu ține de un fals despre care a Mediacritica a anunțat și anterior – că în Republica Moldova vor veni 800 de militari NATO înainte de alegeri.

Într-un video „vociferat” cu AI, această informație inventată este prezentată drept o imixtiune în alegerile parlamentare din 28 septembrie. Curios este că AI-ul le-a jucat festa autorilor și, în loc de militari, acesta anunță că în Republica Moldova vor veni „800 de spartani”. Acest fals alimentează, de fapt, câteva dintre narațiunile promovate constant de propaganda rusă în ultimele luni: înarmarea Moldovei și atragerea în război, controlul din exterior și intenția de falsificare a alegerilor.

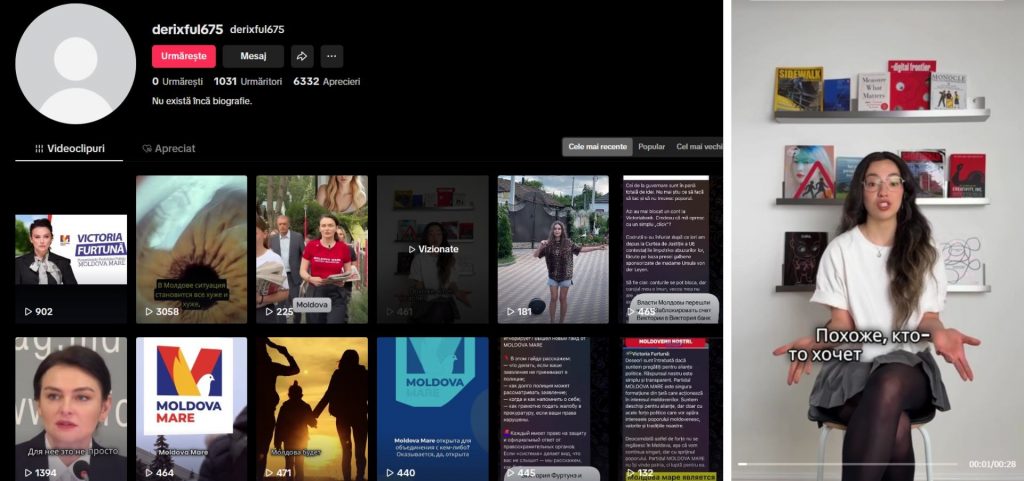

Pagina care a publicat acest video, dar și multe alte postări generate cu ajutorul AI, produce conținut încă din perioada alegerilor prezidențiale din 2024 și are videouri care depășesc 100.000 de vizualizări.

O altă pagină care folosește conținut generat cu AI a distribuit un videoclip despre „împărțirea țării cu ajutorul religiei”. Mesajul este narat de o voce falsă, plasată peste imagini preluate din altă sursă. Cu alte cuvinte, imaginea pare reală, dar vocea este generată artificial.

Cel mai probabil, s-a recurs la această abordare pentru a crea impresia că mesajul aparține unei persoane reale.

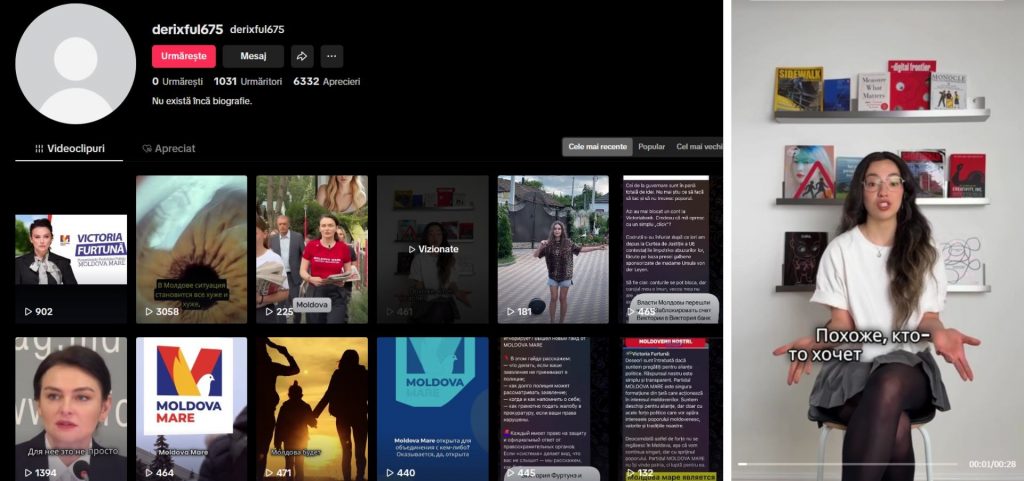

Aceeași pagină publică în special materiale favorabile Victoriei Furtună și care o plasează în lumină pozitivă. Într-un alt videoclip, bunăoară, este prezentată o deplasare electorală a politicienei. De această dată, atât vocea, cât și figura persoanei care „vorbește” în colțul ecranului au fost generate cu AI.

„Bunicuțele” care nu există

În luna august, mai multe surse și conturi propagandistice au avut în vizor condamnarea bașcanei Evghenia Guțul la șapte ani de închisoare cu executare, în dosarul privind finanțarea ilegală a fostului partid Șor. Subiectul a fost promovat mult mai insistent decât alte evenimente de actualitate de pe agenda publică, atât de bloggeri afiliați lui Ilan Șor, cât și prin videouri generate cu inteligență artificială. Un exemplu elocvent sunt „bunicuțele” încătușate de polițiști pentru că „au ieșit să o apere” pe Evghenia Guțul.

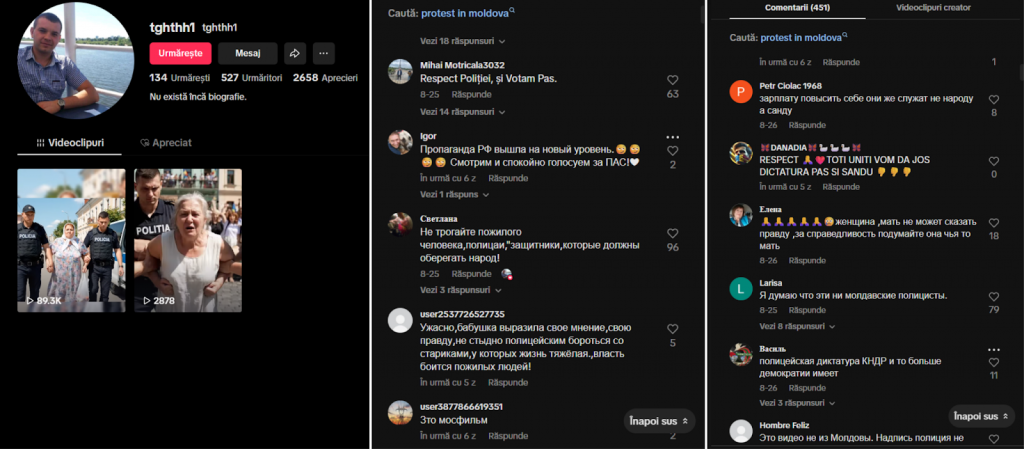

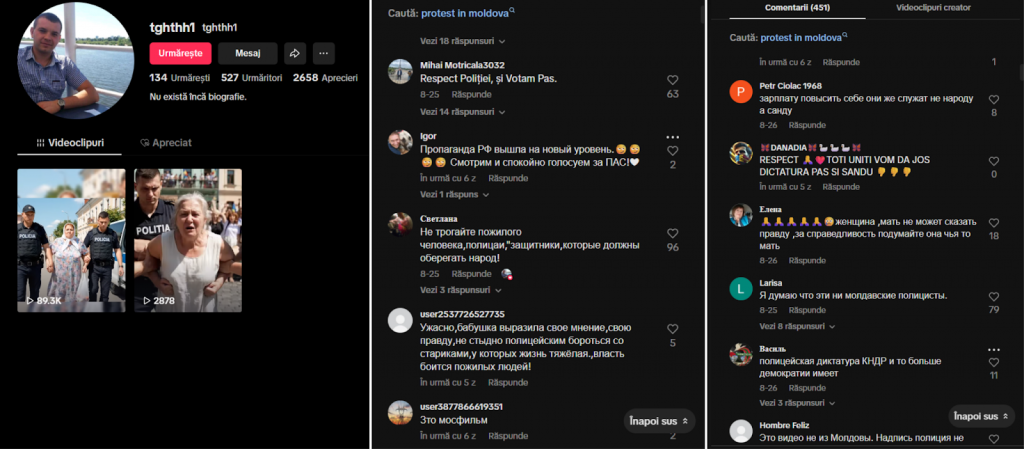

Videourile au practic același subiect: o femeie în vârstă strigă „Libertate pentru Guțul!” și se întreabă „De ce sunt reținută?”. Pe lângă încercarea de a induce falsa iluzie a unei susțineri populare a bașcanei, se dorește a fi transmis mesajul că Poliția își depășește atribuțiile de serviciu și că oamenii din Republica Moldova sunt reținuți sau persecutați pe criterii politice.

Unul dintre aceste videouri, evident generat cu AI, a adunat aproape 90.000 de vizualizări. În comentarii, mai mulți utilizatori reali fie condamnă, fie susțin gestul „poliției”.

Mai nou, pe lângă Ilan Șor, „bunicuțele” au început să se pronunțe activ și în favoarea lui Vladimir Plahotniuc, reținut în Grecia. Într-un video generat cu AI, protagonista susține că s-ar bucura de revenirea fostului lider PD în politică, fiindcă s-a „săturat de gălbeneața aceasta de PAS”.

În alt video, cu peste 200.000 de vizualizări, trei persoane în vârstă cântă și îl cheamă acasă pe Plahotniuc pentru „a o da jos pe Maia”.

Batman „ajunge” în Republica Moldova, la „invitația” PSRM

Inteligența artificială nu este folosită pe TikTok doar pentru a crea iluzia unor persoane și evenimente reale. În unele cazuri, e un instrument de manipulare crasă, cu ajutorul căruia sunt promovate narațiuni false prin imagini generate sută la sută, evident ireale.

De exemplu, într-un video în care se afirmă că „Maia Sandu ar controla justiția”, imaginea președintei este plasată alături de simbolurile comunității LGBTQ+, apelându-se la homofobie pentru a o demoniza.

În alte cazuri, șefa statului figurează pe conturi care distribuie conținut în favoarea lui Ilan Șor, în ipostaze extreme: alături de un demon sau sub forma unei creaturi mitologice. Aceste imagini, însoțite de texte manipulative, sugerează că Maia Sandu ar distruge Moldova. Grupul lor țintă sunt vorbitorii de limbă rusă.

Am identificat și videouri în care partidul de guvernare este prezentat drept corupt, prin imagini menite să stârnească emoții. Persoane îmbrăcate în culorile și cu simbolurile Partidului Acțiune și Solidaritate apar furând bani de la o mamă cu trei copii sau de la bătrâni, pentru a transmite ideea că guvernarea îi jefuiește pe cei mai vulnerabili.

Unele narațiuni sunt servite și prin metode mai creative. Un cont de TikTok, de exemplu, a publicat mai multe videoclipuri generate cu ajutorul inteligenței artificiale, în care personajul Batman „ajunge” în Republica Moldova. O parte dintre acele videouri au tentă politică: supereroul este prezentat ca fiind invitat de „Igor Nicolaevici” [Dodon, n.a.] pentru a o confrunta pe Maia Sandu.

În alte episoade, Republica Moldova este ilustrată drept un stat aflat în criză – cu drumuri proaste, parade LGBTQ+ și o guvernare descrisă ca fiind „formată din hoți”. Narațiunea culminează cu imagini în care Batman conduce cetățenii spre Chișinău, purtând cruci și furci.

Videourile anterioare ies din tiparele obișnuite ale propagandei coordonate și ar putea să fi fost realizate de utilizatori individuali, în baza propriilor lor viziuni politice. Totuși, acest lucru nu anulează faptul că ele propagă narațiuni nocive și chiar incită la ură.

Panica artificială din comentarii

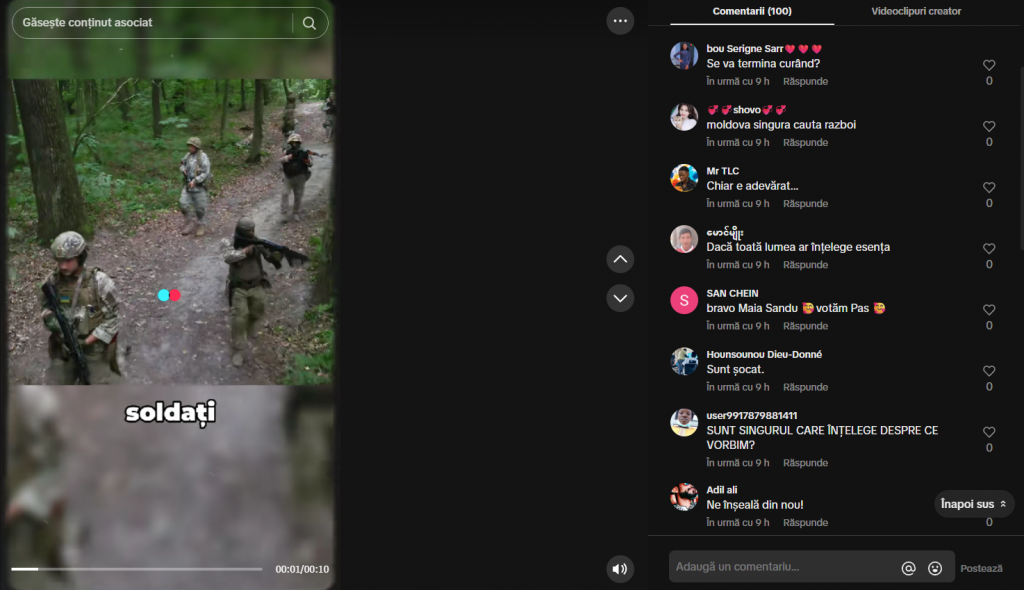

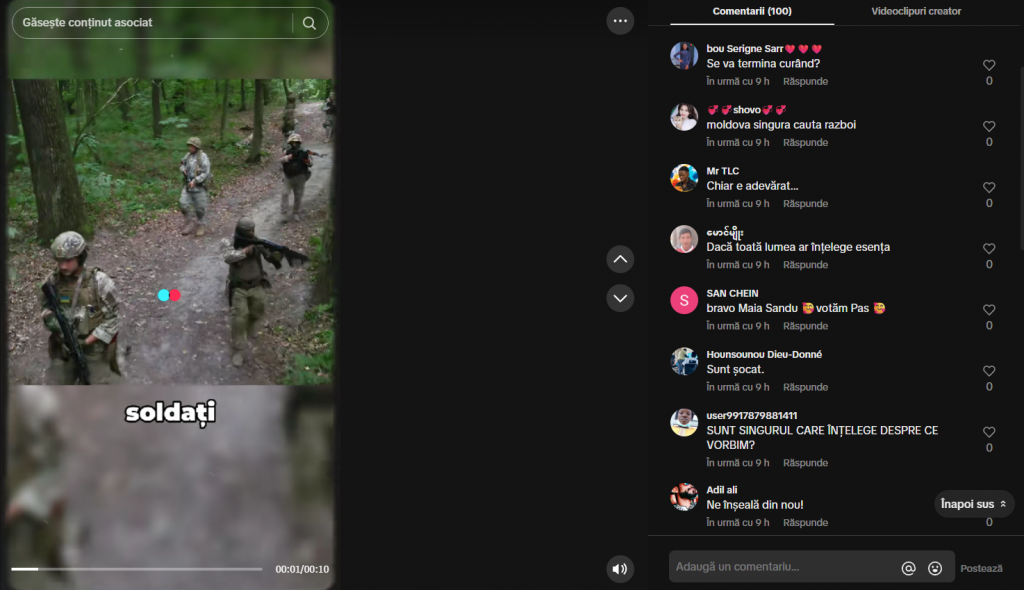

Alături de elementele vizuale și audio, secțiunea de comentarii funcționează adesea ca un instrument suplimentar de manipulare a publicului. De exemplu, la un video fals despre „implicarea Moldovei în războiul din Ucraina” apar comentarii în limba română, scrise de utilizatori din Myanmar, Bangladesh sau Benin. Unul spune că „lumea nu înțelege esența”, altul afirmă că „Moldova singură caută război”, iar al treilea profil susține că situația din țara noastră „șochează”.

Comentariile false sunt utilizate în principal pentru a amplifica vizibilitatea și credibilitatea artificială a unui conținut. Prin crearea unei aparente popularități, algoritmii platformei favorizează distribuirea materialului, ceea ce explică de ce un videoclip analizat de noi a depășit pragul de 100.000 de vizualizări. În paralel, aceste comentarii activează efectul de conformism social («efectul de turmă»), prin care utilizatorii tind să preia opiniile majorității aparente și rareori investighează identitatea reală a celor care le formulează.

CONCLUZII

Acum un an, aproximativ 34 de milioane de fotografii erau generate zilnic cu ajutorul inteligenței artificiale. Volumul de conținut creat cu AI crește rapid și constant și a devenit parte a războaielor informaționale și hibride, iar Republica Moldova nu face nicidecum excepție. În perioade preelectorale și în campaniile electorale videourile false generate și distribuite pe TikTok reprezintă un instrument periculos de manipulare.

Prin voci artificiale credibile, imagini fabricate și comentarii false, care induc o falsă legitimitate socială, aceste materiale distorsionează percepția publică asupra realității și erodează încrederea cetățenilor în procesul electoral, instituțiile statului și în democrație în general.

Într-un context electoral fragil, asemenea practici sporesc riscul de polarizare și radicalizare, transformând rețelele sociale într-un spațiu vulnerabil pentru securitatea informațională a Republicii Moldova.

Monitorizarea a fost desfășurată în cadrul proiectului „Presă rezilientă, alegători informați: protejarea alegerilor din Moldova împotriva dezinformării”, susținut financiar de Ambasada Regatului Țărilor de Jos în Moldova. Opiniile exprimate în analiză aparțin autorilor și nu reflectă neapărat poziția donatorului.

Accesul la instrumentul de monitorizare a TikTok a fost oferit în cadrul proiectului „ProElect – Promovarea responsabilității în procesele electorale din Parteneriatul Estic prin sporirea participării și capacității actorilor civici” implementat de Centrul de Cercetare și Advocacy în Afaceri Europene cu suportul financiar al Uniunii Europene și Equal Rights & Independent Media (ERIM).