Mai multe imagini distorsionate care îl vizează pe președintele Federației Ruse, Vladimir Putin, în timpul vizitei sale la Mariupol sau la întâlnirea cu președintele Chinei, Xi Jinping, au alimentat zilele acestea zvonurile despre presupusele „dubluri” ale liderului de la Kremlin. O analiză publicată pe France 24 demontează aceste mituri.

A trimis Vladimir Putin o „dublură” de-a sa în cadrul vizitei oficiale în orașul ucrainean ocupat Mariupol? În susținerea acestei teorii, începând cu 20 martie, mai multe publicații au distribuit un colaj foto reprezentându-l pe Vladimir Putin în diferiți ani și care ar arăta diferențe fizice pe fața liderului de la Kremlin. În aceste imagini sunt evidențiate diferențe legate de forma feței lui Putin, pentru a demonstra că nu adevăratul Vladimir Putin ar fi cel care a fost la Mariupol.

Montajul a fost publicat pe Twitter și de Anton Gherașcenko, consilier al ministrului de Interne al Ucrainei, postarea fiind distribuită de aproape 6.000 de ori. „Care crezi că este cel adevărat?” întreabă în limba engleză oficialul.

Potrivit analizei publicată pe France 24, datele și locurile asociate cu aceste imagini nu sunt corecte. „Dacă sunt vizibile diferențe, este pentru că aceste imagini au fost făcute la câțiva ani distanță și arată diferite expresii faciale ale președintelui rus”, precizează sursa. Prima fotografie este făcută în 2020, nu în 2023. Jurnaliștii de la France 24 au inversat imaginea și au putut-o găsi într-un articol publicat pe 23 februarie 2020 de agenția de presă rusă TASS.

A doua fotografie este o imagine făcută la Mariupol, și nu la Sevastopol. Este luată dintr-un reportaj publicat pe 19 martie 2023 de instituția media „Izviestia”, după cum indică portalul italian de verificare a informației Open.online. A treia fotografie este o imagine dintr-un reportaj filmat la Mariupol. Prin urmare, corespunde aceluiași loc și aceleași zile ca a doua imagine, în timp ce publicațiile recente le asociază cu locuri și date diferite.

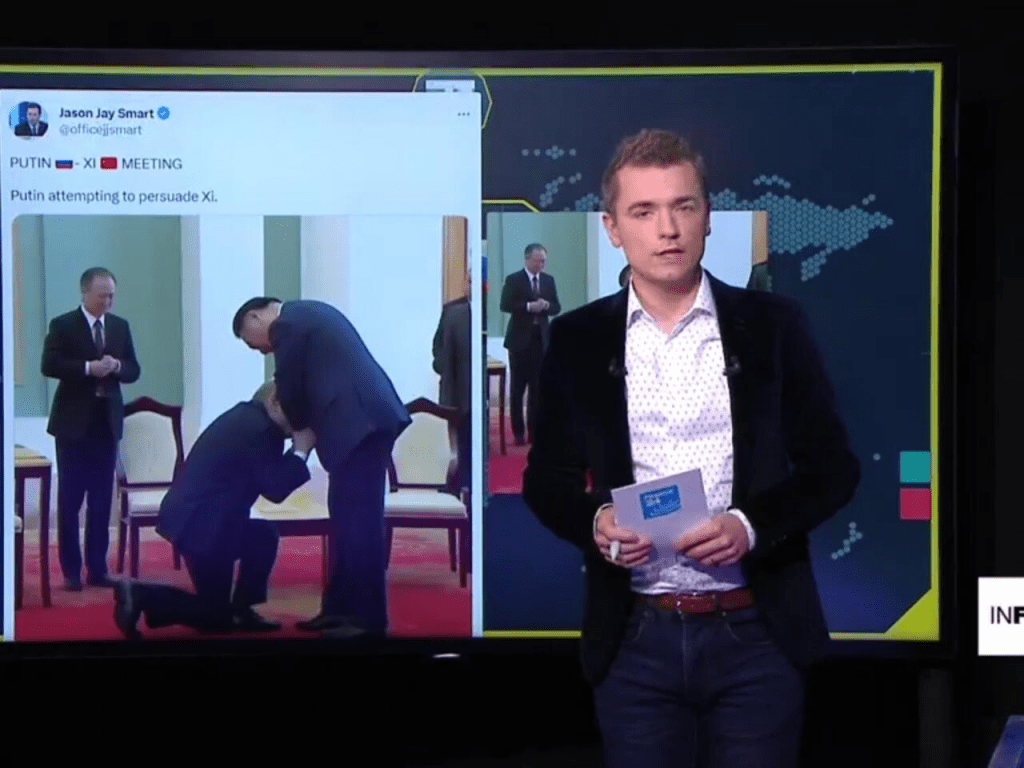

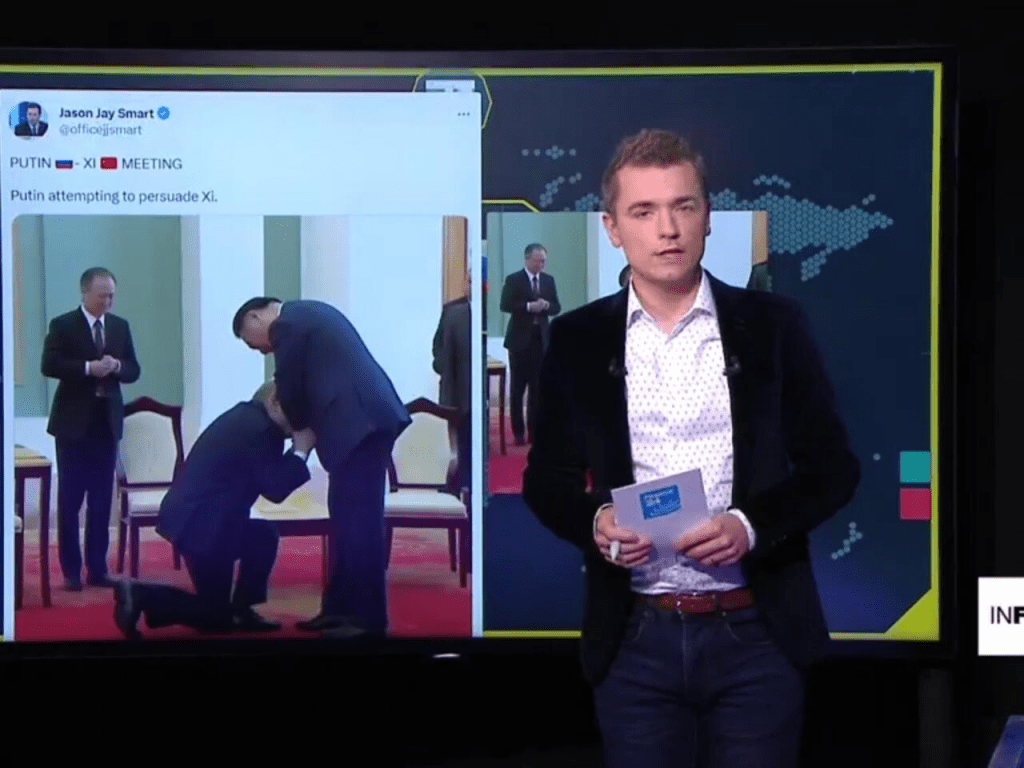

O altă imagine trucată, distribuită recent intens pe Twitter, se referă la întâlnirea președintelui chinez Xi Jinping cu omologul său rus la Moscova. Potrivit echipei italiene de verificare a faptelor Open.online, citată de France 24, fotografia a fost realizată de către Inteligența Artificială și nu a circulat decât pe rețele sociale.

DEEPFAKE, TEHNOLOGIA LA CARE SĂ FIM ATENȚI

În context, amintim despre un fenomen care prinde din ce în ce mai mult teren în secolul 21. Este vorba despre deepfake – tehnologia de creare a unor videoclipuri sau imagini false, care par să fie autentice și să prezinte evenimente sau persoane reale. Acestea sunt create cu ajutorul inteligenței artificiale și a învățării automate, prin care se pot modifica sau distorsiona cu ușurință fotografii, înregistrări video sau audio.

Experții în domeniu consideră că deepfake-ul este mult mai periculos și cu un impact mult mai puternic asupra publicului decât știrile false cu care ne-am obișnuit în ultimii ani. Asta pentru că fenomenul cuprinde toate elementele unui produs media integrat: text + fotografie + video + audio. Combinația dintre inteligența artificială (deep learning) și fals (fake) are la bază un concept numit Generative Adversarial Network (rețea generativă adversarială), ce poate fi folosit pentru a reproduce imagini video și sunet superficial, care par a fi reale pentru ochiul uman. Mediacritica a abordat subiectul într-o ediție anterioară a Podcastului #cuMINTE.

Mai multe indicii ne pot ajuta să identificăm falsurile profunde pe cont propriu și cu ajutorul AI:

- Mișcarea nenaturală a ochilor. Mișcările ochilor care nu par naturale – sau lipsa mișcării ochilor, cum ar fi absența clipirii – sunt semnale că ar putea fi vorba de un deepfake. Este o provocare să reproduci actul de a clipi într-un mod care să pară natural. De asemenea, este dificil să reproduci mișcările oculare ale unei persoane reale și asta pentru că ochii cuiva urmăresc de obicei persoana cu care se discută.

- Expresii faciale lipsite de naturalețe. Când ceva arată dubios la o față, ar putea semnala transformarea feței. Acest lucru se întâmplă atunci când o imagine a fost suprapusă peste alta.

- Poziționare incomodă a caracteristicilor faciale. Dacă fața cuiva este îndreptată într-o direcție, iar ochii – în alta, ar trebui să ne punem întrebări.

- Mișcări nenaturale ale corpului. Dacă cineva pare distorsionat atunci când se întoarce în lateral sau își mișcă capul sau dacă mișcările sale sunt sacadate și dezarticulate de la un cadru la altul, videoclipul ar putea fi fals.

- Culori nenaturală. Tonul anormal al pielii, decolorarea, iluminarea ciudată și umbrele deplasate sunt toate semne că ceea ce vedem este probabil fals.

- Păr care nu arată real. Nu vei vedea într-un deepfake păr creț sau vâlvoi. De ce? Imaginile false nu pot genera aceste caracteristici individuale.

- Dinți care nu arată tocmai real. Este posibil ca algoritmii să nu poată genera dinți individuali, așa că absența contururilor dinților individuali ar putea fi un indiciu.

- Încețoșare sau nealiniere. Dacă marginile imaginilor sunt neclare sau imaginile sunt nealiniate – de exemplu, acolo unde fața și gâtul se unesc cu corpul – putem presupune că ceva nu este în regulă.