Într-un interviu pentru platforma Euvsdisinfo.eu, Dr. Benjamin Lange, un etician cu expertiză în domeniul Inteligenței Artificiale (IA), susține că trebuie să învățăm să recunoaștem conținutul produs cu ajutorul IA și să verificăm acel conținut, pentru că poate conține greșeli.

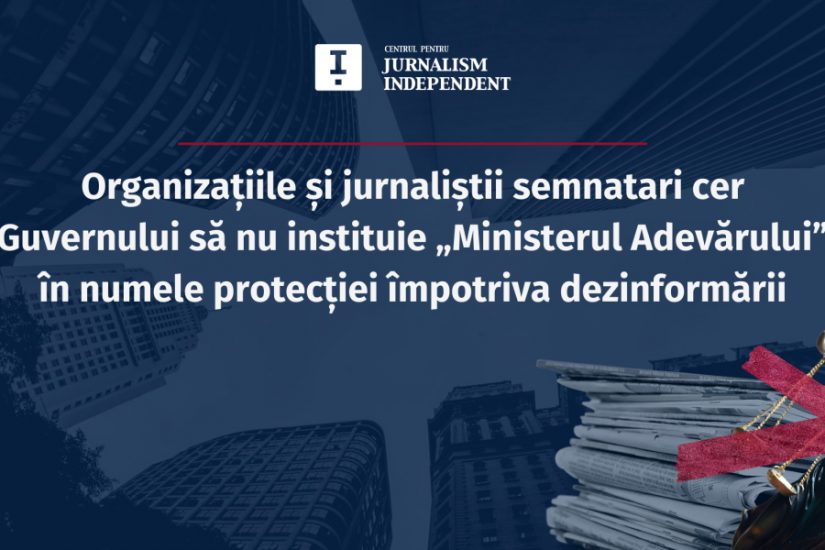

„Am putea (…) să intensificăm semnificativ eforturile noastre de educare a publicului larg cu privire la IA și la relația sa cu obiceiurile noastre de consum și creare a informațiilor, începând cu școlile. Dezvoltarea rezilienței și a spiritului critic la scară largă, pentru a putea naviga în mediul nostru informațional în era IA, mi se pare mult mai rodnică decât să ne bazăm exclusiv pe măsuri reactive”, consideră cercetătorul și consultantul în etică, Dr. Lange.

În același timp, eticianul sugerează că este nevoie de instrumente adecvate și la îndemână pentru utilizarea tehnologiilor IA.

„În ceea ce privește amenințările pe care le prezintă în special IA asupra mediului nostru informațional, trebuie să ne asigurăm că avem îndrumări adecvate pentru utilizarea acestor tehnologii, atât prin autoreglementare, cât și prin legi stricte. Acest lucru ar putea include cerința adăugării de îndrumări tehnice, cum ar fi filigranele digitale, la Interfețele de Programare a Aplicațiilor (API-uri) folosite în software-ul condus de IA, pentru a atenua riscul abuzului și manipulării informațiilor”, a declarat Dr. Lange.

Referitor la interacțiunea dintre inteligența artificială și manipularea informațiilor, Dr. Lange aduce în discuție impactul IA generativă. El subliniază că, deși există progrese în detectarea dezinformării, tehnologiile IA generative, cum ar fi generatoarele de text sau imagine, „au adus cu sine noi provocări”. Aceste tehnologii pot amplifica răspândirea dezinformării, sub formă de text sau imagine.

„Aș încuraja pe toată lumea să acorde atenție înțelegerii mai bune a modului de funcționare a unor astfel de modele, cum ar fi modul în care generează text sau imagini și cum putem învăța să identificăm mai bine rezultatele IA generative. Există indicii care ne ajută în acest sens, cum ar fi modelele sintactice ale textului (adică ordinea cuvintelor acceptabilă în cadrul frazelor, structura proprie a frazelor) sau anumite elemente ale imaginilor pe care inteligența artificială nu le poate crea încă destul de bine (de exemplu, mâini, proporții logice, proporții relative între anumite elemente, fundaluri detaliate). Acest lucru înseamnă, de asemenea, că tehnici dovedite pentru verificare a faptelor, cum ar fi verificarea surselor, devin și mai importante”, a punctat sursa.

Într-o notă optimistă, Dr. Lange remarcă faptul că avem și mijloace pentru a combate dezinformarea prin intermediul IA. De exemplu, tehnologiile de detectare pot identifica conturi false sau conținut care a fost ușor modificat pentru a răspândi dezinformarea. Totuși, el subliniază necesitatea unor eforturi concertate pentru a educa publicul cu privire la IA și impactul noilor tehnologii asupra mediului informațional.